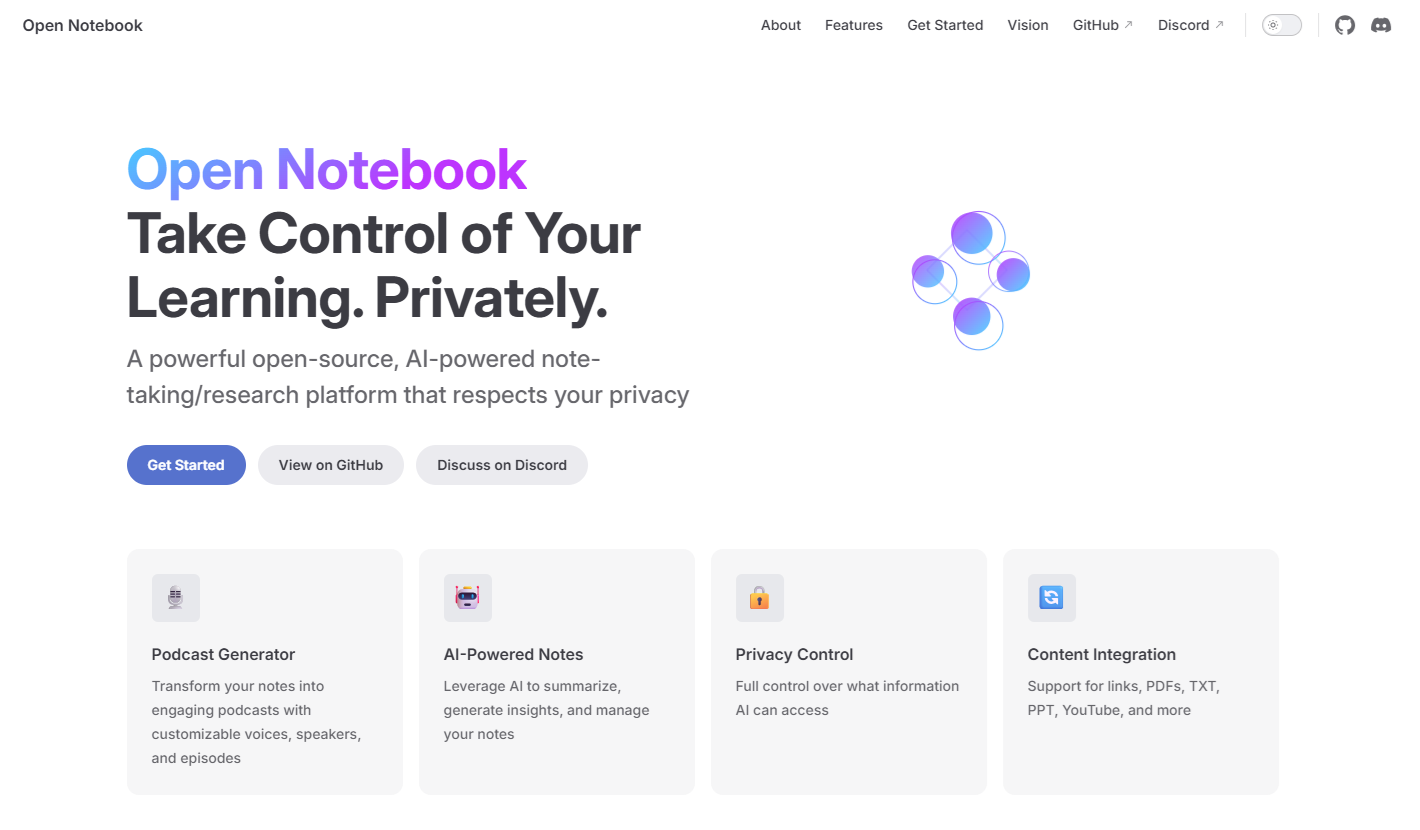

近年、AIを活用したノートブック型の情報管理サービスとして注目されるNotebook LMですが、これをローカル環境で再現する方法として「Open Notebook」と「Ollama」を組み合わせる手法があります。本記事では、Windows環境でのセットアップから簡単な利用方法までを解説します。

この方法では、データやモデルをすべて自分のPC内で管理できるため、クラウドにアップロードする必要がなく、外部への情報漏洩リスクを気にせずに安全に利用できます。

必要な環境

- Windows 10/11

- Docker Desktop

- Ollama(ローカルでLLMを管理するツール)

- Open Notebook(ノートブック型RAGサービス)

Ollamaのインストールとモデルの準備

1) Ollamaを公式サイトからダウンロードしてインストールします。

2) インストール後、以下のモデルを取得します。

ollama pull gemma3:4b

ollama pull gemma3:1b

※ちなみにメモリ16GBのPCで4bの方はかなり重たくなる…

1bだと問題なく動いた。

3) モデルが正しくインストールされたか確認します。

ollama list

出力例:

NAME ID SIZE MODIFIED

gemma3:4b a2af6cc3eb7f 3.3 GB 8 days ago

gemma3:1b 8648f39daa8f 815 MB 8 days ago

4) 埋め込み用のモデルも取得しておくと、文書検索やRAGに利用できます。

ollama pull nomic-embed-text

Open Notebookのセットアップ

1) プロジェクトディレクトリを作成し以下のファイルを配置します。

docker-compose.yml

services:

open_notebook:

image: lfnovo/open_notebook:v1-latest-single

ports:

- "8502:8502" # Web UI

- "5055:5055" # API

environment:

# === Add this ===

- LLM_PROVIDER=ollama

- EMBEDDING_PROVIDER=ollama

- OLLAMA_API_BASE=http://host.docker.internal:11434

# Database connection (required)

- SURREAL_URL=ws://localhost:8000/rpc

- SURREAL_USER=root

- SURREAL_PASSWORD=root

- SURREAL_NAMESPACE=open_notebook

- SURREAL_DATABASE=production

volumes:

- ./notebook_data:/app/data

- ./surreal_data:/mydata

restart: always

2) プロジェクトディレクトリでDocker Composeを使ってサービスを起動します。

docker compose up -d

3) 起動後、ブラウザで以下のURLにアクセスします。

http://localhost:8502/

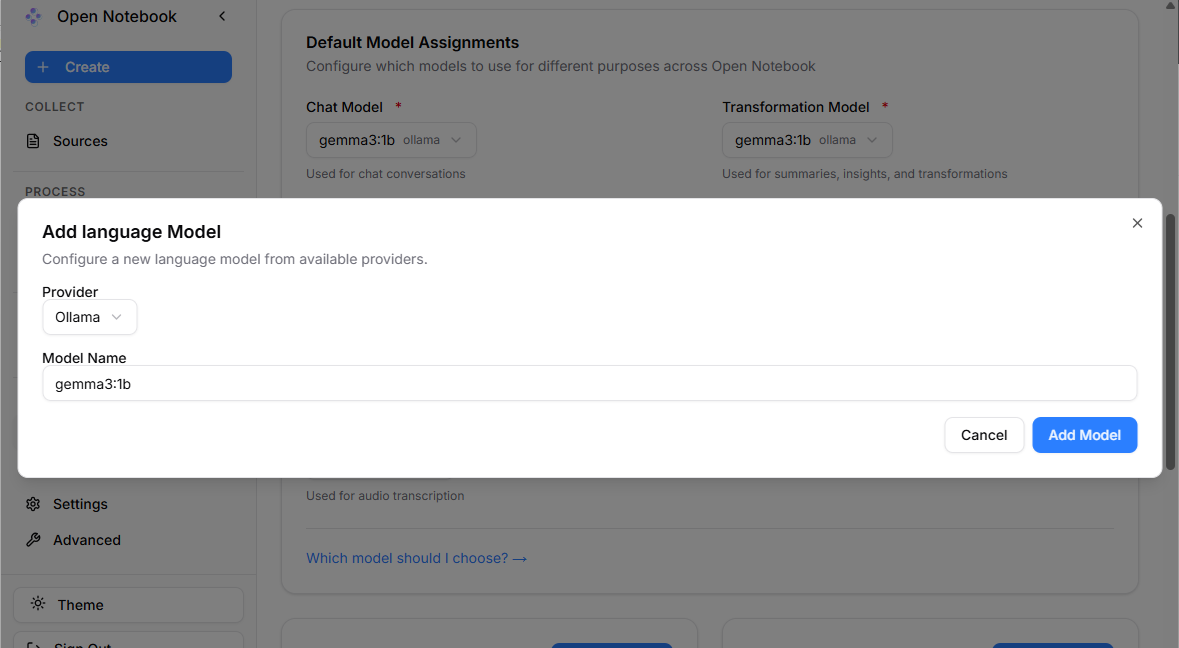

モデルの設定

1) Open Notebookの画面で「MANAGE > Models」を開きます。

2) 「Language Models」や「Embedding Models」でOllamaでインストールしたモデル(例:gemma3:4bやgemma3:1b)を追加します。

3) 「Default Model Assignments」で、追加したモデルを選択します。

※ちなみに以下に記載のモデルが追加できる

ノートブックに資料を読み込む

1) 「+ Create > Source」をクリックし、エクセルやPDFなどの資料をアップロードします。

2) アップロードした資料に対してプロンプトを入力し、内容が正しく読み取れるか確認します。

これで、ローカル環境でNotebookLMのように文書を学習させ、質問応答や要約を行うサービスを構築できます。Open NotebookとOllamaを組み合わせることで、クラウドに依存せず自分のPC上でLLMを活用したナレッジ管理が可能になります。

コメント